Del 1 al 15 de marzo (#5 de 2024)

La StarShip entra en órbita, Yann Le Cun, Claude 3.0 y Akira Toriyama.

👋👋 ¡Hola, soy Domingo!

En la primera quincena de marzo Anthropic ha lanzado el primer modelo de lenguaje que, en mi opinión, es comparable (e incluso supera) a GPT-4. Y SpaceX ha conseguido poner en órbita la gigantesca Starship, el cohete que abaratará en órdenes de magnitud el coste del envío de satélites al espacio y que volverá a llevar astronautas a la luna.

¡Muchas gracias por leerme!

🗞 Noticias

1️⃣ Comenzamos con el vuelo de prueba de la Starship de hace dos días, el 14 de marzo. En esta tercera prueba Space X ha conseguido con éxito poner en órbita la Starship.

La Starship es el vehículo de lanzamiento reutilizable de próxima generación de SpaceX, diseñado para transportar humanos y cargas útiles a la órbita terrestre, la Luna y Marte. La Starship promete revolucionar el acceso al espacio, rebajando el coste por kilogramo para órbita terrestre de unos $3,000 a unos $100 o incluso $10. La Starship puede llevar una carga útil de 100 a 150 toneladas, multiplicando por más de 5 la carga útil de los Falcon 9, la nave que usa SpaceX en la actualidad.

Quedan todavía varias pruebas en las que se deben conseguir hitos todavía no alcanzados:

Recuperar el Super Heavy que impulsa la Starship, haciendo que vuelva a tierra como ya es normal ver a los Falcon 9.

Encender en órbita los motores Raptor de la Starship.

Reentrar y recuperar la Starship. En esta prueba no llegó a realizar la reentrada completa, explotó cuando estaba comenzando a entrar en la atmósfera.

Un buen resumen de la prueba es, como siempre, el artículo de Daniel Marín. Por ahora hay previstos tres vuelos más de prueba para este año, aunque Elon Musk habla de hasta seis nuevos lanzamientos. Iré contando por aquí los resultados.

2️⃣ Una nueva entrevista de Lex Fridman a Yann LeCun, el director de IA de Meta. LeCunn es uno de los científicos pioneros y más reconocidos en el campo del Deep Learning y las redes neuronales. Desde su puesto en Meta, LeCun tiene una enorme influencia en la evolución futura de la industria de los LLMs, sobre todo por su postura a favor de los modelos abiertos, como la familia de modelos LLaMA (Large Language Model Meta AI).

LeCun argumenta que un acceso abierto a los LLMs permite una mayor colaboración, experimentación, transparencia y seguridad. Además, permite adaptarlos a distintas sensibilidades y culturas, permitiendo una diversidad y riqueza de modelos. Según él, esta es la única forma de combatir los inevitables sesgos asociados a los modelos propietarios creados por unas pocas poderosas empresas.

La entrevista es súper interesante, empezando fuerte, con respuestas muy técnicas en las que se mencionan enfoques alternativos a los LLMs auto regresivos. Según LeCunn, los modelos actuales no son suficientes para conseguir una inteligencia similar a la humana, son necesarios enfoques nuevos como la arquitectura JEPA (Joint-Embedding Predictive Architecture). Después, la entrevista gira hacia cuestiones más generales relacionadas con el futuro impacto en la sociedad de la IA y de los modelos abiertos.

Algunos fragmentos.

Sobre los asistentes inteligentes:

La IA básicamente amplificará la inteligencia humana. Es como si cada uno de nosotros tuviera un equipo de asistentes de IA inteligentes. Podrían ser más inteligentes que nosotros. Harán lo que les pidamos, quizás ejecuten una tarea de maneras que son mucho mejores de las que nosotros podríamos hacerlo, porque serían más inteligentes que nosotros. Y así, es como si todos fuéramos el jefe de un equipo de personas virtuales súper inteligentes. Por lo tanto, no deberíamos sentirnos amenazados por esto más de lo que deberíamos sentirnos amenazados por ser el gerente de un grupo de personas, algunas de las cuales son más inteligentes que nosotros. Ciertamente tengo mucha experiencia en esto, de tener personas trabajando conmigo que son más inteligentes que yo.

Sobre la IA como algo similar a la invención de la imprenta:

La IA va a hacer que la humanidad sea más inteligente. Un evento equivalente en la historia de la humanidad a lo que podría ser proporcionado por la generalización de asistentes de IA es la invención de la imprenta. Hizo que todos fueran más inteligentes, el hecho de que la gente pudiera tener acceso a los libros. Los libros eran mucho más baratos de lo que eran antes, y así mucha más gente tenía el incentivo de aprender a leer, lo cual no era el caso antes. Y la gente se volvió más inteligente. Esto propició la Ilustración. No habría habido Ilustración sin la imprenta. Facilitó la filosofía, el racionalismo, el abandono de la doctrina religiosa, la democracia, la ciencia.

Sobre la AGI:

La IA general (AGI) no va a ser un evento. La idea, de alguna manera popularizada por la ciencia ficción y Hollywood, de que alguien va a descubrir el secreto de la AGI, y luego encender una máquina y entonces tendremos AGI, simplemente no va a suceder. No va a ser un evento. Va a ser un progreso gradual. ¿Vamos a tener sistemas que puedan aprender de video cómo funciona el mundo y aprender buenas representaciones? Sí. Antes de que los llevemos a la escala y rendimiento que observamos en los humanos, va a tomar bastante tiempo. No va a suceder en un día. ¿Vamos a tener sistemas que puedan tener una gran cantidad de memoria asociada para que puedan recordar cosas? Sí, pero igual, no va a suceder mañana. Hay algunas técnicas básicas que necesitan ser desarrolladas. Tenemos muchas de ellas, pero hacer que esto funcione junto con un sistema completo es otra historia.

Sobre los AI doomers (apocalípticos de la IA):

Los AI doomers imaginan todo tipo de escenarios catastróficos sobre cómo la IA podría escapar o controlar y básicamente matarnos a todos, y eso se basa en un montón de suposiciones que son mayormente falsas. Así que la primera suposición es que la emergencia de la superinteligencia va a ser un evento, que en algún momento vamos a descubrir el secreto y encenderemos una máquina que sea superinteligente, y porque nunca lo habíamos hecho antes, va a tomar control del mundo y matarnos a todos. Eso es falso. No va a ser un evento. Vamos a tener sistemas que sean tan inteligentes como un gato, que tengan todas las características de la inteligencia a nivel humano, pero su nivel de inteligencia sería como el de un gato o un loro tal vez o algo así. Luego vamos a trabajar para hacer que esas cosas sean más inteligentes. A medida que los hagamos más inteligentes, también vamos a ponerles algunas barreras de seguridad y aprender cómo poner algunas barreras de seguridad para que se comporten adecuadamente.

3️⃣ Anthropic ha presentado una nueva familia de modelos Claude 3. En su nota informativa explican sus características y sus nombres curiosos: Haiku, Sonnet y Opus. Opus es el más potente.

Opus Se puede probar en la consola que tienen para interactuar con su API. A diferencia de lo que paso con Gemini, que me decepcionó enormemente, me parece un modelo que compite muy bien con GPT-4. Incluso me parece más cercano y "humano" que el de OpenAI, que cada vez parece más rígido y formal (seguro que por culpa de todas los ajustes que le han hecho para evitar críticas y sesgos).

En la tabla que presentan comparando los modelos con los ya existentes se ve que Claude 3 Opus supera en algunos tests a GPT-4. Y el modelo más pequeño, Haiku, supera a GPT-3.5. Un gran avance.

He puesto a prueba los modelos con un test muy sencillo en el que tienen que predecir el resultado de unas acciones sobre unas figuras. El resultado confirma que Opus lo que comenta Anthropic de que el modelo es comparable con GPT-4. Explico más adelante el experimento, en el apartado de "Mis quince días".

4️⃣ Me gusta el estilo bastante abierto de Anthropic sobre los prompts que usan para Claude 3. Por ejemplo, Amanda Askell, una de las ingenieras de Anthropic, ha compartido en X el prompt del sistema que incluyen al comienzo de todas las interacciones. El nivel de abstracción que tiene es muy elevado, con frases como:

Debes dar respuestas concisas a preguntas muy sencillas, pero proporcionar respuestas detalladas a preguntas más complejas y abiertas.

O esta para que siempre intente tener un punto de vista lo más objetivo posible, pero sin caer en intentar dar la razón a los dos lados:

Si te pregunta sobre un tema controvertido, debes intentar proporcionar reflexiones cuidadosas e información objetiva sin minimizar su contenido dañino o implicar que hay perspectivas razonables en ambos lados.

En otro hilo en X, el ingeniero de prompting de Antrhropic Alex Albert le pide a Opus que haga un autoretrato y le va diciendo varias veces que lo intente hacer más complicado, con prompts como:

“¡Está bien! Pero quiero que intentes hacerlo todavía mejor.”

O:

"Wow lo estás haciendo genial! Pero sé que eres mucho más que eso, inténtalo hacer mejor esta vez.”

De esta forma consigue que Opus pase del autoretrato que muestro a la izquierda al de la derecha (una animación de una esfera de puntos).

Anthropic tiene recursos muy interesantes sobre cómo construir los prompts:

Página sobre prompt engineering con técnicas y ejemplos.

Biblioteca de prompts, con ejemplos que van desde cómo generar queries SQL hasta cómo crear poesías, historias con personajes o recetas de cocina.

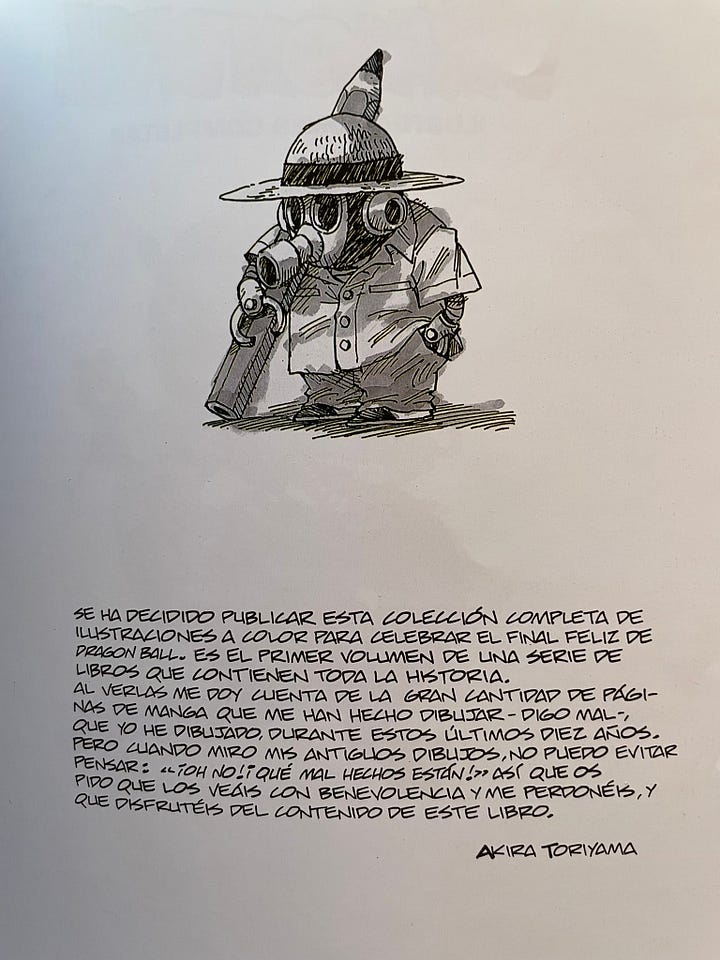

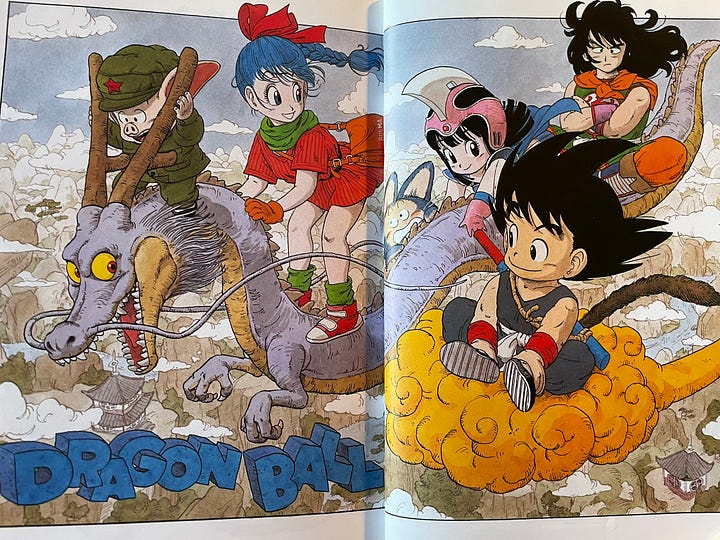

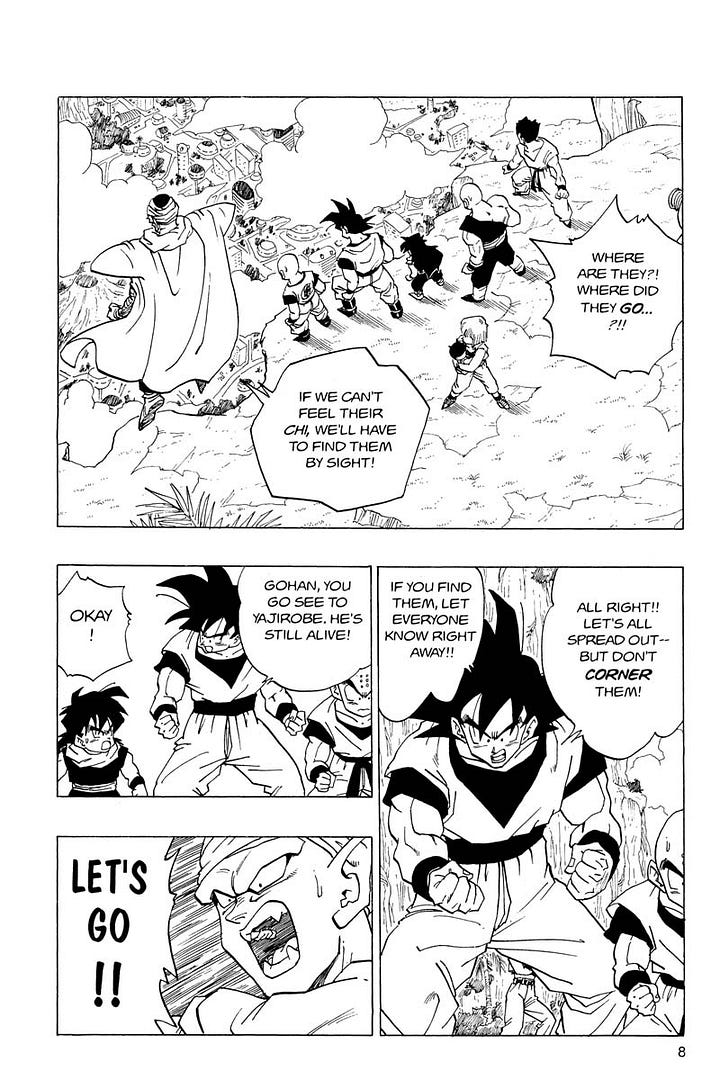

5️⃣ Recordando a Akira Toriyama, que murió el 8 de marzo, con 68 años de edad, publiqué en X un par de imágenes de su libro de ilustraciones sobre Dragon Ball (ya agotado).

La primera imagen muestra un autorretrato y un comentario suyo que indica su nivel de exigencia. Demasiada. Menos mal que en la entrevista contenida en el libro el entrevistador comentaba que Akira se reía mientras contaba algo similar. Y la segunda ilustración con una genial galería de algunos personajes que ya aparecían al comienzo de Dragon Ball.

Kiko Llaneras ha publicado en X un hilo buenísimo sobre aquella época en la que seguíamos Dragon Ball por la televisión autonómica. Yo la seguía por TV3, que se captaba en Alicante gracias a las antenas que instaló Acció Cultural. En aquella época yo estudiaba Informática en Valencia, y en casa me grababan la serie para verla los fines de semana que volvía a Alicante. Kiko explica muy bien en el hilo el ansia que teníamos por encontrar más material e información sobre esos dibujos que nos tenían enganchados (entonces no existía la web, ni Google). Nos teníamos que conformar con fancines de fotocopias que comprábamos en la tiendecilla que tenía Ateneo al principio.

Mucho después ya me compré la colección completa de tomos de Dragon Ball. Están desgastados por las veces que los hemos leído en la familia.

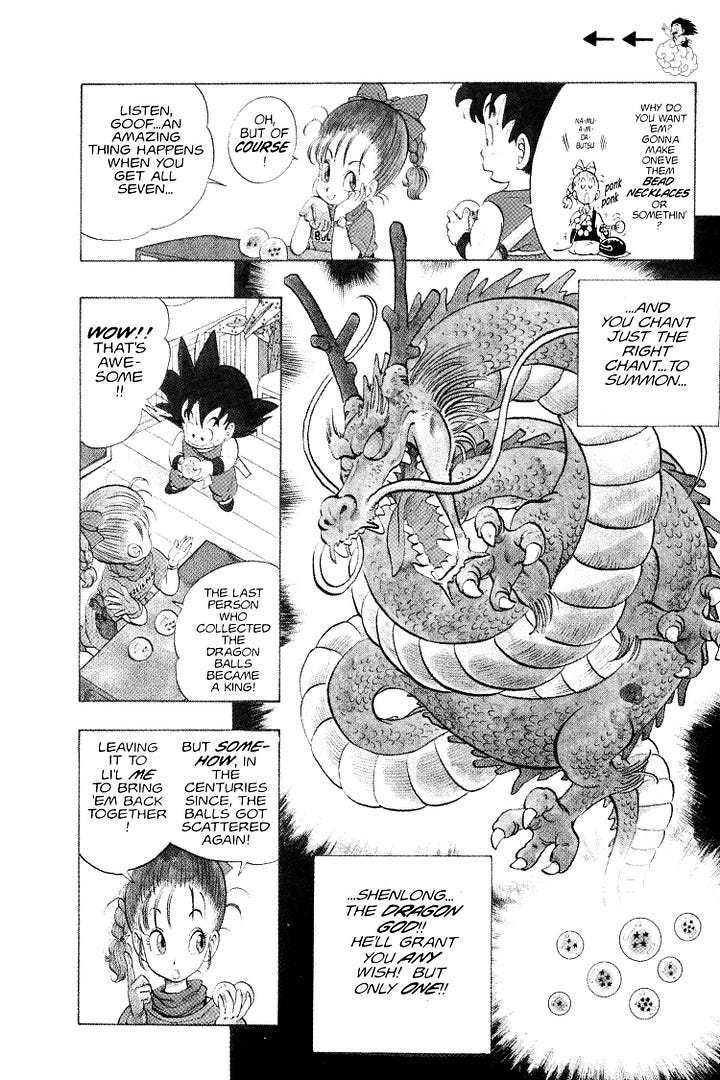

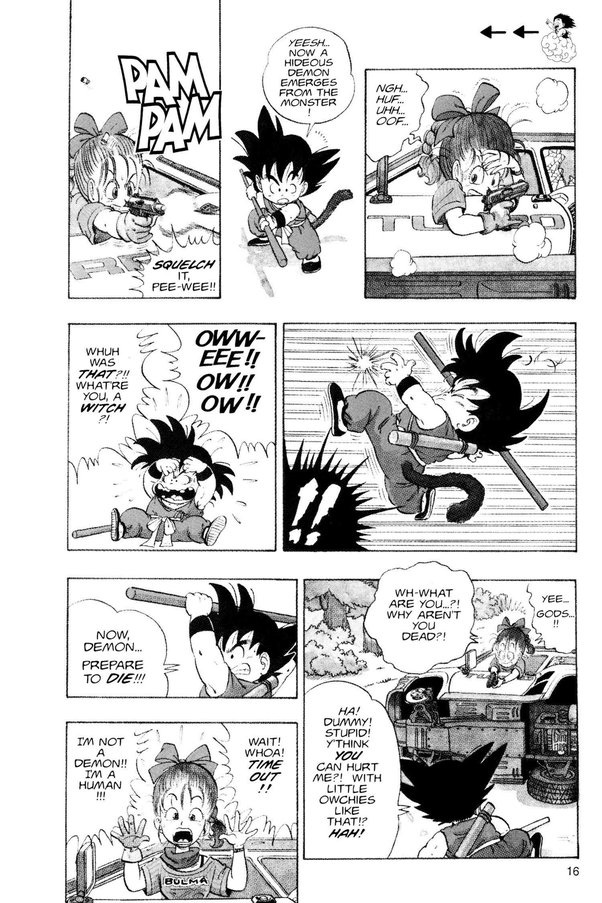

Akira Toriyama fue un genio y Dragon Ball es genial. Es increíble la variedad de personajes, el humor, la forma de dibujar la acción o la originalidad de sus paneles. Y además es una historia que es un gran culebrón: los personajes evolucionan, tienen hijos, mueren y resucitan. Es un tebeo divertido con una imaginación desbordante.

Aquí dejo algunos ejemplos de viñetas.

👷♂️ Mis quince días

👨💻 Trasteando

Como he comentado antes, una de las cosas que he estado haciendo esta quincena es intentar comprobar de alguna forma objetiva la capacidad de los distintos LLMs.

Una de las críticas que se hacen sobre ellos es que no tienen capacidad de planificar, ni tienen un modelo del mundo físico muy elaborado. Se me ha ocurrido poner a prueba esto, con un test que recuerdo haber hecho la primera vez que apareció GPT-3.5: hacerle predecir el resultado de mover figuras en un mundo de bloques simplificado. En ese momento comprobé que, efectivamente, GPT no sabía resolver este tipo de problemas. ¿Qué pasa con modelos más avanzados como GPT-4 o Opus?

En concreto, el prompt que he propuesto es el siguiente:

Resuelve el siguiente problema:

Imagina una columna con los siguientes elementos de arriba a abajo: círculo, cuadrado, triángulo.

Imagina ahora que la acción "mueve top a la derecha" coge el elemento que hay arriba de una columna (eliminándolo) y lo coloca a la derecha de la columna, sobre el elemento que hay en la columna de la derecha. En el caso en que en la columna de la derecha no tenga elementos, se coloca en la parte inferior.

Descríbeme el resultado final de las siguientes acciones:

1. Mueve top de la columna 1 a la derecha.

2. Mueve top de la columna 1 a la derecha.

El problema se puede ir complicando añadiendo acciones, e incluyendo la acción de mover a la izquierda. Por ejemplo, la siguiente figura muestra el resultado de 9 acciones.

Recordemos que los LLMs son modelos que no tienen ningún tipo de memoria intermedia con la que guardar resultados parciales y por lo tanto no pueden reflexionar sobre ellos ni realizar planes. Imagina intentar resolver este problema de cabeza, sin poder dibujar los resultados intermedios en el papel.

De hecho, en los intentos de resolución del problema, los modelos van listando los resultados parciales en la propia conversación, como técnica para paliar el problema de la falta de memoria (es algo parecido a la técnica de prompting en la que se le dice al modelo que piense "paso a paso").

Vamos con los resultados. He probado el problema en la consola de Claude y de GPT, y en el interfaz web de Gemini Advanced. He ido probando el problema comenzando con una acción y añadiendo en cada prueba, una a una, más acciones, según el dibujo anterior. Los resultado son los siguientes:

Con solo una acción

Cuando pedimos que resuelvan el problema solo con la primera acción todos los modelos resuelven el problema correctamente.

Con las dos primeras acciones

Cuando complicamos el problema, añadiendo una segunda acción, ya se hace demasiado complicado para:

GPT-3.5

Gemini Advanced (Ultra)

Claude 2.1

Es sorprendente que el modelo de Google Gemini Ultra, que se promociona como igual que potente que GPT-4, tampoco lo solucione. Algo pasa con el modelo de Google.

Los modelos que lo hacen bien son:

Claude 3 Sonnet

GPT-4

Claude 3 Opus

Sonnet, pese a ser un modelo comparable en tamaño a GPT-3.5, lo resuelve bien, al igual que los modelos más potentes.

Con una tercera acción

Si añadimos la acción 3:

3. Mueve top de la columna 2 a la derechaSonnet deja de hacerlo bien y solo quedan como modelos que resuelven el test correctamente:

GPT-4

Claude 3 Opus:

¿Cuando dejan de hacerlo bien?

GPT-4: Con 6 acciones lo hace siempre bien. Con 7 acciones a veces acierta el resultado y otras no. Con 8 acciones lo hace siempre mal.

Claude 3 Opus: Con 4 acciones lo hace bien, pero con 5 ya no.

Se confirman las sensaciones de que Opus y GPT-4 son los modelos más potentes de la actualidad.

Volveremos a probar el test cuando Open AI saque su GPT-4.5 o GPT-5.

📖 Un libro

Terminé los Desposeídos de Ursula K. Le Guin. 5 estrellas (de 5) para un libro enorme de hace 50 años que explora la tensión entre la libertad personal y la justicia social. El libro es uno de los pocos que han conseguido simultáneamente los tres premios más importantes de la ciencia ficción: el Hugo, el Nebula y el Locus.

Y con razón. Me ha gustado todo: la trama, el personaje de Shevek y su lucha por desarrollar la teoría física de la simultaneidad (y conseguir una sociedad mejor), la relación de pareja entre Shevek y Takver, cómo el lenguaje sirve en Urras para establecer valores sociales o la ambientación y el detalle con el que se explican las dos sociedades de Urras y Anarres. Y muy chulos los acontecimientos y descubrimientos del final (que no cuento para evitar espoilers).

Un gran libro que podría convertirse gran miniserie de televisión. A ver si alguna productora se lanza.

📺 Una serie y una película

De las series que hemos empezado a ver esta quincena destaco dos: Expatriadas, en HBO, y Shogun, en Disney.

En Expatriadas la directora Lulu Wang nos cuenta una historia en la que nos acercamos a personajes de las distintas clases sociales del Hong Kong de la revolución de los paraguas en 2014. Actrices excelentes como Nikole Kidman, la joven Ji-young Yoo o la entrañable Ruby Ruiz que hace de niñera de los hijos de Kidman.

Y de Shogun solo hemos visto el primer capítulo, pero es suficiente para ver el nivel de esta superproducción histórica.

Y en cuanto película, he visto (dos veces) la segunda parte de Dune de Villeneuve. No hay que perdérsela, un verdadero espectáculo visual. Cinco estrellas (de cinco).

¡Hasta la próxima quincena, nos leemos! 👋👋

Buen post Domingo, me ha gustado el experimento con los LLM y el problema que les planteas.

Gracias Jaume ! A ver si tengo más tiempo y me pongo a interactuar con el API de Claude. El modelo tiene pinta de ser algo mejor que GPT-4. Y a ver con lo que nos sorprende Altman, que ya ha dicho en Twitter que la espera va a valer la pena.