Del 1 al 15 de abril (#7 de 2024)

Temperatura del mundo, las Vision Pro ¿éxito o fracaso?, Apple y las IAs generativas, Mountain Valley, un sencillo problema que los LLMs no pueden resolver.

👋👋 ¡Hola, soy Domingo!

Ya hemos pasado el primer tercio de año y nos metemos de lleno en 2024. Ya no nos confundimos al escribir 2024. Y ya llevamos 7 entregas de esta newsletter que empezó siendo una idea feliz de año nuevo (“a ver qué tal”) y que cada vez me divierte más escribir.

Faltan menos de 3 meses para la conferencia de desarrolladores de Apple (WWDC24) en la que parece que Apple va a presentar novedades sobre aplicaciones de IA generativa en sus productos. ¿Qué hay de cierto en ello?

Vamos allá. ¡Muchas gracias por leerme!

🗞 Noticias

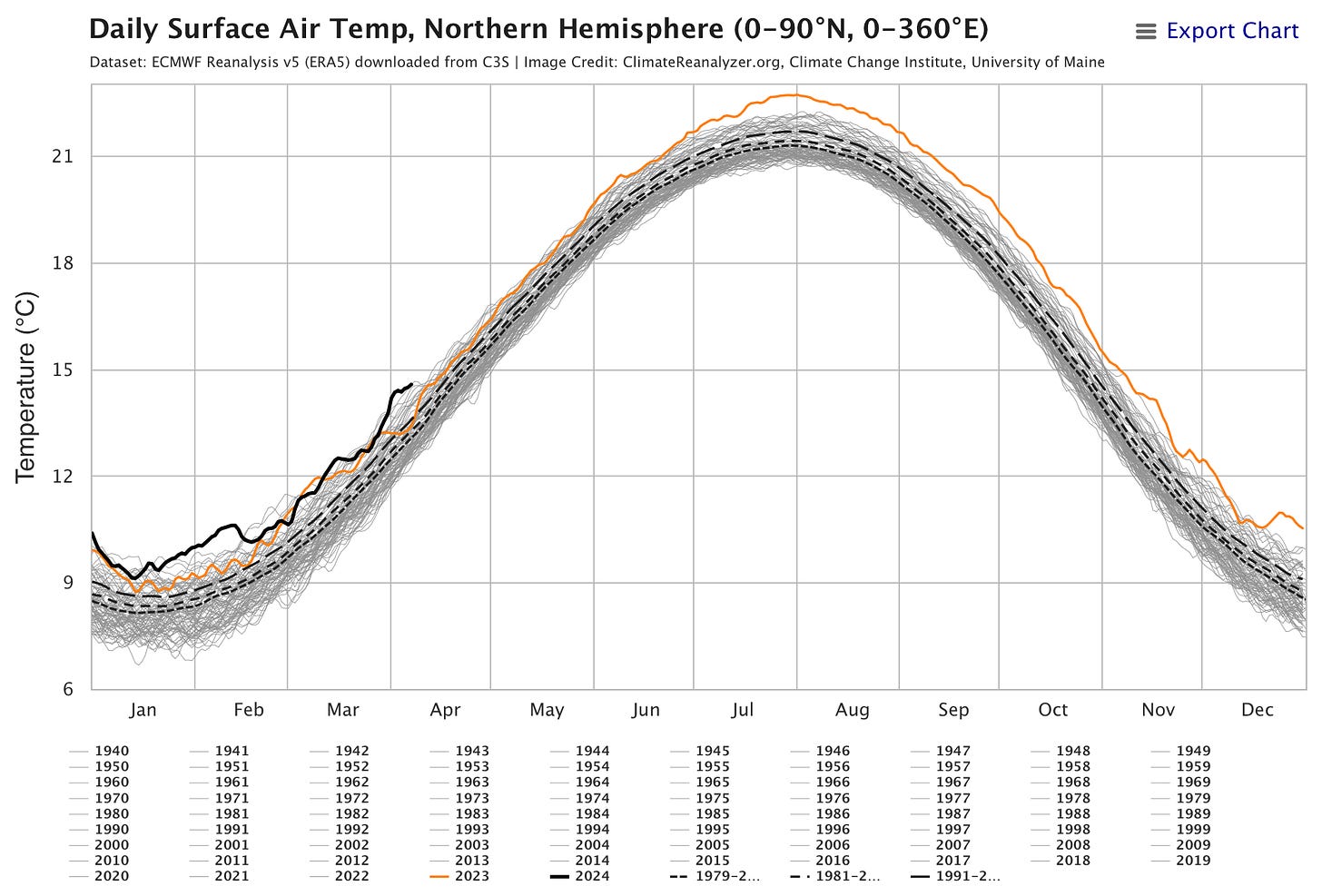

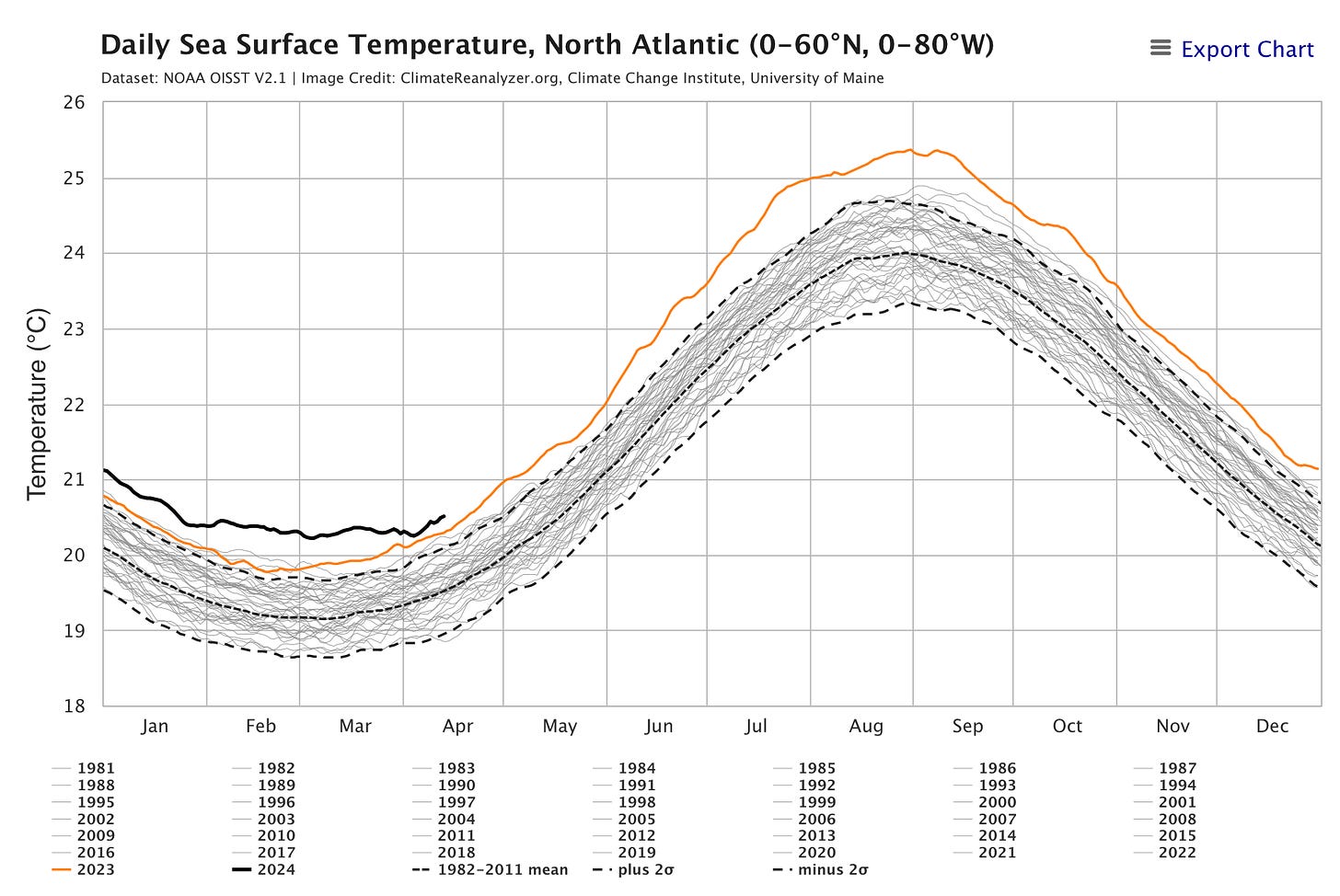

1️⃣ ¿Cómo de caluroso va a ser este verano? He descubierto la web https://climatereanalyzer.org, una web del Instituto del Cambio Climático de la Universidad de Maine. Recogen a diario información de múltiples fuentes y las muestran en un formato gráfico muy manejable.

Un par de páginas destacables de la web, que ya he añadido en mis favoritos para visitarlas cada mes, son la de la evolución de la temperatura de la superficie y la evolución de la temperatura del mar. Se puede seleccionar la zona del mundo sobre la que se quiere consultar la información y obtener datos, por ejemplo, del hemisferio norte y del atlántico norte.

En las figuras se muestran los últimos datos a fecha de ayer. El registro del año pasado (en naranja) se sale de todas las escalas. Esto muestra lo que todos sentimos el verano pasado: que fue el más caluroso de toda la historia. Y el registro del año actual (en negro) está por encima, aunque parece que la pendiente es menos inclinada y (siendo optimista) puede que no suba tanto como el año pasado. Habrá que ir visitando la web para confirmarlo.

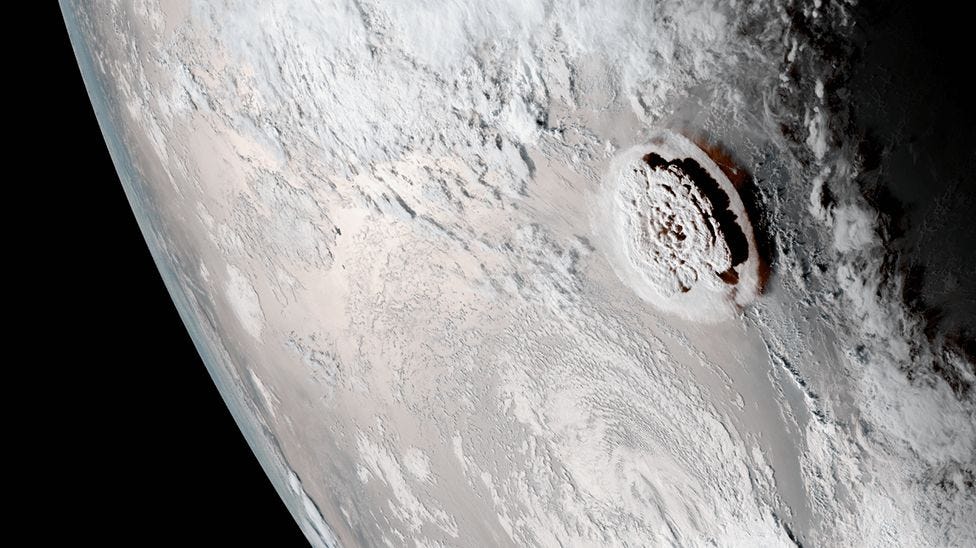

¿Por qué han subido tanto las temperaturas desde el año pasado? No se sabe bien del todo. Los modelos de evolución de la temperatura que se usan para predecir el cambio climático son modelos a largo plazo, que no sirven para explicar fluctuaciones puntuales de un año. Una de las razones que algunos científicos han propuesto es la gran erupción del volcán submarino Hunga Tonga, situado en el Pacífico sur, en enero de 2022.

Fue una erupción extraordinaria que envió 146 millones de toneladas de vapor de agua a la estratosfera de la Tierra (alrededor de un 10% del vapor de agua ya existente en esa capa de la atmósfera). A diferencia de erupciones anteriores como las de Krakatoa o Pinatubo, en las que se inyectaron en la atmósfera gases y cenizas que tuvieron un efecto temporal de enfriamiento de la superficie terrestre, el vapor de agua tiene un efecto invernadero que incrementa la temperatura y produce cambios químicos que pueden disminuir el ozono.

No se ha estudiado demasiado este efecto invernadero, y no hay consenso entre los científicos sobre su efecto real, pero puede ser que sea responsable en parte del incremento extraordinario de la temperatura en estos últimos años. El efecto desaparecerá cuando el extra de vapor de agua termine eliminándose de la atmósfera. Aunque no hay estimaciones del tiempo necesario, los expertos hablan de algunos años. Esperemos que no sean muchos.

2️⃣ Ya hay gente diciendo que las Vision Pro han sido un fracaso. Otros preguntándose si se arrepienten de haberlas comprado.

Todavía es muy pronto para ponerle adjetivos la lanzamiento. Pero sí que podemos reflexionar sobre el producto y su posible evolución. Me interesa la evolución de las Vision Pro por varias razones.

Primero, desde el punto de vista tecnológico, es uno de los dispositivos computacionales que integra más elementos que son estado del arte. Comprobar la evolución de las gafas va a ser equivalente a comprobar la evolución de las tecnologías de computación más avanzadas: procesadores, pantallas, cámaras, sensores LiDAR, etc. Además, a nivel de diseño de producto, va a ser muy interesante comprobar la dirección en la que avanzan los modelos en los próximos años. ¿Aumentará Apple la resolución de las gafas, a expensas de mantener su peso? ¿Habrá un modelo más ligero? ¿Cambiará la pantalla frontal con los ojos?

La segunda razón es el desde el punto de vista del software. ¿Qué nuevos estilos de interacción se van a crear? ¿Hasta qué punto el dispositivo va a aumentar nuestras capacidades? ¿Qué se va ha poder hacer con esta nueva herramienta computacional? Siempre me ha interesado ver la computación desde el punto de vista de la metáfora de Steve Jobs de la bicicleta de la mente 1 y creo que las Vision Pro pueden ser un paso espectacular en esta dirección.

Y la tercera razón es desde el punto de vista del entretenimiento.

Casi todas las semanas mi mujer y yo vamos al cine. Salimos un rato, vemos una peli, cenamos. Eso no se puede sustituir por ver una película con las gafas, por muy espectacular que sea el ambiente de la torre de los Vengadores, el sonido espacial o las tres dimensiones. Pero eso no quiere decir que nunca vayas a ver una película en el visor. Por ejemplo, cada vez será más normal hacerlo viajando en avión o en tren. El vídeo no mató a la estrella de la radio; no acertaron The Buggles. Al revés. Ahora vemos YouTube y escuchamos podcasts.

También tengo curiosidad por las llamadas experiencias inmersivas. ¿Se van a producir muchas más? ¿Vamos a poder ver obras de teatro, musicales o conciertos? No somos aficionados al fútbol, pero sí que vemos a veces a Nadal o Alcaraz. O los partidos de basket de la selección. ¿Dentro de 10 años será posible verlos en directo como experiencias inmersivas?

Una novedad espectacular que ha introducido Apple esta quincena en la nueva versión beta del VisionOS 1.1 son las personas espaciales. Ahora las personas a las que llamas por FaceTime ya no aparecen en una ventana, sino que aparecen junto a ti, en tu espacio, en tres dimensiones. Puedes ver su cara y sus manos. Puedes acercarte, agacharte, hacer movimientos juntos e incluso chocar las manos.

Y además, casi tan importante como lo anterior, todas las personas en la conversación pueden compartir e interactuar con aplicaciones usando SharePlay. Por ejemplo, escribir en una pizarra compartida o examinar figuras 3D colocadas en ella, o ver una película o una serie al mismo tiempo.

En la parte negativa, Apple ha lanzado una película inmersiva de pocos minutos con un resumen de jugadas de fútbol de la liga americana. La película tiene problemas, porque el montaje está pensado para una película normal, con cortes demasiado rápidos para una experiencia inmersiva.

El futuro nos dirá cómo evolucionan las gafas. No comparto la opinión de Marco Arment en el episodio de ATP de que ya se puede considerar un fracaso. Es todavía demasiado pronto para hacer un juicio de valor tan rotundo, apenas han pasado tres meses desde que salieron a la venta. Estoy más con Siracusa, Mike Hurley y Casey Liss o Jason Snell de que por ahora son un experimento en evolución.

Apple acaba de dar un nuevo empujón a su promoción, publicando una nota de prensa sobre su uso en empresas y sacándolas de nuevo en su página home, resaltando experiencias como la de usarlas en viajes de avión.

Es la forma de hacer que triunfen: encontrar casos de éxitos e ir tirando a partir de ahí. Veremos cómo evolucionan. Como dice Siracusa en el podcast anterior, hay que esperar como mínimo tres años para declararlas éxito o fracaso. Propongo que apostemos sobre tres posibles escenarios:

Producto de enorme éxito, del que Apple presenta varias versiones con distintas configuraciones y prestaciones (similar a lo que es en la actualidad el MacBook).

Producto de éxito limitado, pero de nicho. Bien considerado y bien soportado por Apple, con frecuentes actualizaciones de software y contenidos, y con actualizaciones de hardware más especiadas (similar al Apple Watch Ultra en la actualidad).

Producto que Apple ha dejado sin actualizar durante mucho tiempo, con pocas apuestas de diversificación, con poca inversión en software y contenido, y con cada vez menos éxito (similar a lo que está pasando con el Mac Pro).

Yo, por ahora, soy medio optimista y apuesto por el escenario 2. ¡Volveré a revisar esta predicción dentro de un año!

3️⃣ Siguiendo con Apple, se oye mucho runrún sobre que en la próxima WWDC24 van a lanzar novedades importantes sobre IA generativa. Hay rumores de conversaciones con Google y OpenAI o de que Apple está desarrollando sus propios modelos.

Incluso hay gente que está diciendo que Apple está lanzando LLMs, como se sugiere en el siguiente tweet.

¿Qué hay de cierto en todo esto? Me gustaría comentarlo, para explicar cómo diferenciar los rumores de las noticias.

En el campo del hardware, ya estamos acostumbrados a los ciclos de los rumores: las cadenas de suministros chinas lanzan alguna noticia basada en algunas unidades de prueba o componentes, Mark Gurman lo confirma más o menos, algunas webs más o menos serias (del estilo de MacRumors, 9to5Mac, Applesfera, Xataca) recogen los rumores identificándolos como tales y todo termina desmadrándose en artículos de click-bait de publicaciones tipo Forocoches que venden el rumor como una noticia ya confirmada.

Está pasando algo parecido con la IA generativa. Pero ahora el origen de los rumores es distinto: las publicaciones científicas.

Apple tiene un departamento bastante potente de investigación: Apple Machine Learning Research.

Si entramos en la web, vemos todas la publicaciones científicas (papers) que investigadores de Apple están presentando en revistas y congresos. Algunos papers tienen incluso un repositorio en GitHub. Por ejemplo, este de febrero de 2024, Scalable Pre-training of Large Autoregressive Image Model, en el que se presentan distintos modelos de visión aplicables a LLMs, tiene este repositorio.

Además, antes de ser aceptados en congresos, los papers se suben también al repositorio científico arXiv, algo que es habitual en campos como computación o física. Esto es el caso de los papers relacionados con el modelo de lenguaje Ferret:

(Abril 2024) Ferret-v2: An Improved Baseline for Referring and Grounding with Large Language Models

(Abril 2024) Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs

(Octubre 2023) Ferret: Refer and Ground Anything Anywhere at Any Granularity - repositorio en GitHub.

Uno de los primeros autores de estos papers es el joven investigador Haotian Zhang, un brillante científico computacional que presentó la tesis doctoral hace solo 2 años en la Universidad de Washington y que está trabajando en Apple desde entonces.

Entonces ¿Apple ha lanzado algún LLM? No. Apple está empezando a investigar en el tema. Además, Apple está (por ahora) teniendo una filosofía bastante transparente con respecto a su departamento de investigación, publicando en abierto todos los resultados. Pero recordemos que son sólo eso. Papers científicos. No son modelos en producción, ni siquiera en pre-producción. La diferencia entre un paper científico y un producto es similar a la diferencia entre una patente y un producto final. Un producto final es el resultado de decenas de patentes y papers.

OpenAI se fundó en 2016, en 2018 publicaron un paper llamado Improving Language Understanding by Generative Pre-Training, que fue el origen de GPT. En 2019 presentaron GPT-2, en 2020 GPT-3 y en diciembre de 2022 ChatGPT.

Apple está ahora, en 2024, en un momento similar al que estaba OpenAI en 2018/19. Puede que en un par de años puedan lanzar un modelo. Pero no ahora.

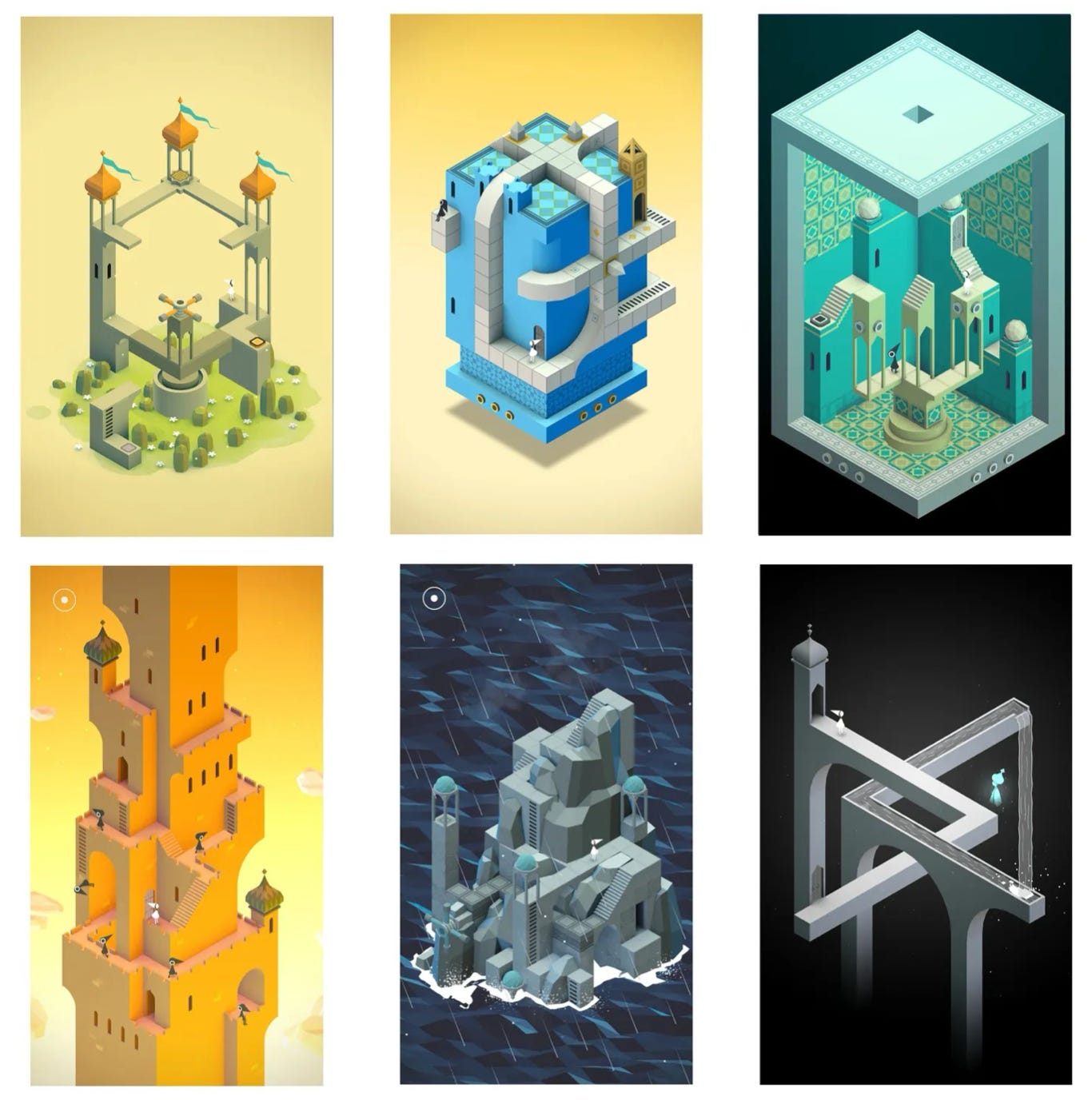

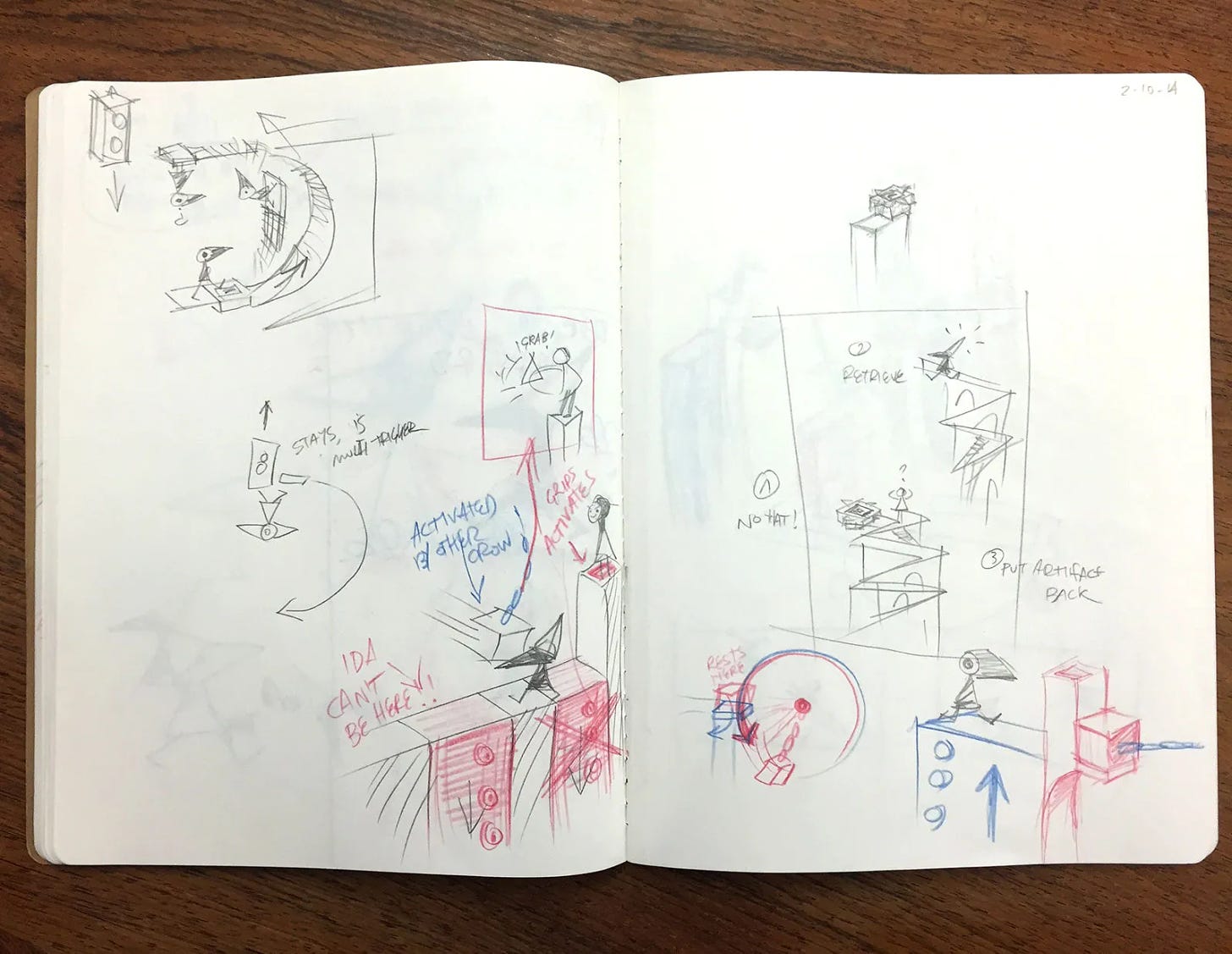

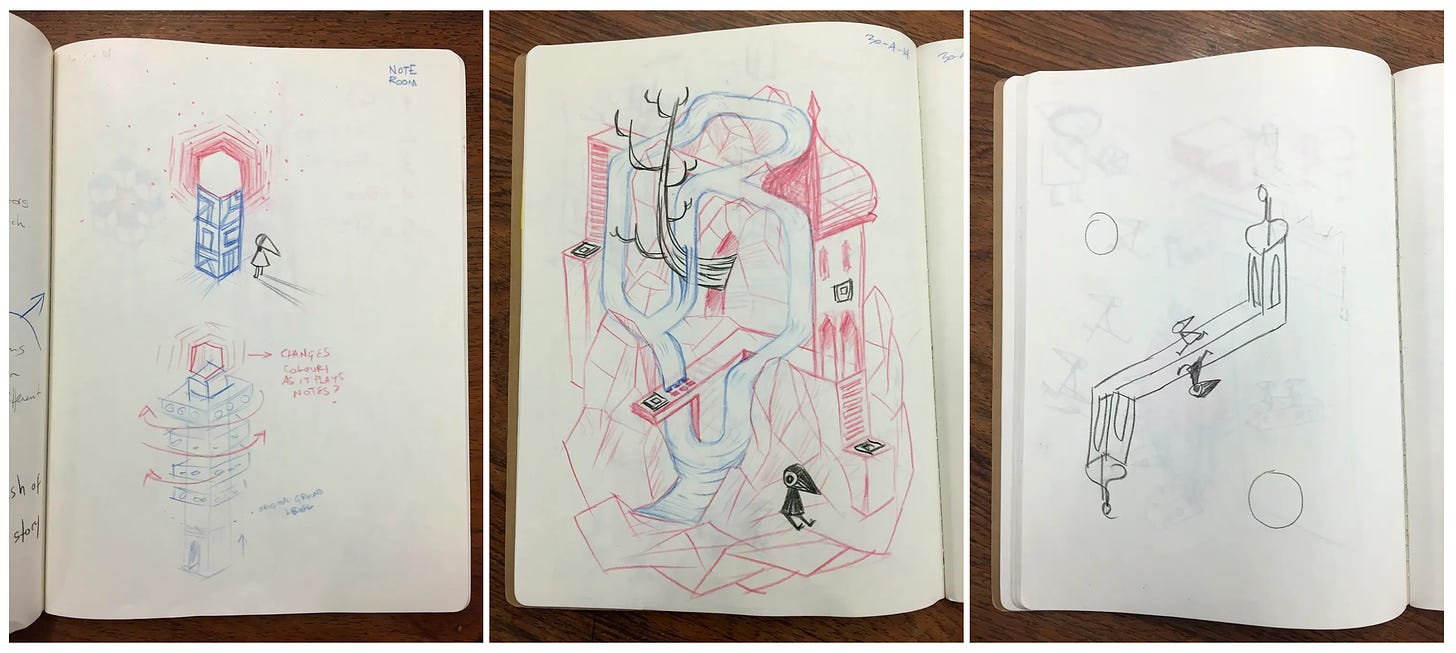

4️⃣ Se han cumplido 10 años de Mountain Valley, el revolucionario juego de la compañía británica ustwo games que nos enganchó a muchos por su jugabilidad, gráficos e interacciones.

La compañía ha publicado un recordatorio en X y un vídeo conmemorativo en su web. Se han publicado también algunos artículos muy interesantes sobre su historia (en gamesindustry.biz y en wallpaper.com) de los que me encantan los bocetos de algunas dinámicas y puzzles del juego.

Si no has jugado todavía, está disponible para varias plataformas. Si jugaste hace 10 años, como yo, seguro que no te acuerdas de las soluciones y puedes volver a disfrutar con él. ¡Corred, insensatos!

5️⃣ Terminamos con una historia curiosa sobre un problema difícil de resolver por los LLMs, el denominado problema A::B.

El 6 de abril, Victor Taelin, un programador y emprendedor brasileño, publicó en X un reto que tuvo más de 1 millón de visualizaciones: daría 10.000 dólares a quien encontrara un prompt con el que algún modelo resolviera un problema lógico que él creía imposible de resolver por los modelos actuales.

Veamos rápido el problema, no es muy complicado. Taelin lo plantea en este post en X del 5 de abril y lo detalla más en este Gist. Se trata de procesar una cadena formada por los símbolos A#, #A, B# y #B. Por ejemplo, la cadena:

B# A# #В #А В#Hay que comprobar los símbolos de izquierda a derecha y de dos en dos. Por defecto, no hay que hacer nada y hay que dejar los símbolos tal cual. Pero en el caso en que los símbolos tengan sus # enfrentados, mirándose uno al otro, hay que aplicar las siguientes reglas de transformación:

Regla 1: A# #A => se eliminan ambos símbolos

Regla 2: B# #B => se eliminan ambos símbolos

Regla 3: A# #B => se transforman en #B A#

Regla 4: B# #A => se transforman en #A B#Una vez se ha hecho la transformación, se avanza y se sigue procesando el resto de la cadena, dejando atrás los símbolos transformados. Cuando se ha terminado de procesar la cadena, se vuelve a empezar. El proceso termina cuando la cadena resultante ya no cambia.

Por ejemplo, el resultado de procesar la cadena original sería el siguiente. Pongo entre corchetes la pareja de símbolos que se procesan en cada paso:

Pasada 1

========

[B# A#] #В #А В# => B# y A# no tienen los # enfrentados, se dejan igual

B# [A# #B] #А В# => (Regla 3, se transforman) => B# #B A# #A B#

B# #B A# [#A B#] => Se dejan igual

B# #B A# #A B#

Pasada 2

========

[B# #B] A# #A B# => (Regla 2, se eliminan) => A# #A B#

[A# #A] B# => (Regla 1, se eliminan) => B#

B#Entonces, el resultado final de procesar la cadena

B# A# #В #А В#es la cadena

B#Mucha gente intentó el reto. Había que conseguir un prompt para que un LLM consiguiera procesar cadenas de longitud de 12 símbolos con un 90% de éxito. En muy pocos días alguien lo consiguió, usando Claude Opus, con un prompt complicadísimo de 700 líneas, en el que se daban muchísimas explicaciones y muchísimos ejemplos. Un poco más tarde otra persona dio otra solución más corta de 400 líneas, con la que ganó 2.500 dólares.

Al final Taelin tuvo que dar el reto por perdido. Y, curiosamente, el LLM ganador no fue GPT-4, sino Claude. Bien por Anthropic.

Pero a mi no me convence. Cualquiera de nosotros que hemos leído el problema lo hemos entendido con muchísimas menos de 400 líneas y con un solo ejemplo. Supongo que cada nueva generación de LLMs ganará en capacidad de abstracción y podrá resolver el problema con un prompt más pequeño. Habrá que probarlo con GPT-5.

El problema que tendremos para repetir el problema con modelos siguientes (GPT-6 y posteriores) es que los nuevos LLMs se entrenarán también leyendo todos estos posts, mensajes y ficheros y sabrán resolver el problema “de fábrica”. Pero GPT-5 ya debe estar en el horno y con él sí que podremos hacer la prueba, no le ha dado tiempo a leer esto en su entrenamiento.

👷♂️ Mis quince días

👨💻 Trasteando

Se ha creado en mi universidad, la Universidad de Alicante, un grupo de trabajo en Moodle para compartir iniciativas relacionadas con las IAs generativas y los modelos de lenguaje. Formo parte del grupo y he subido un vídeo de 20 minutos en el que comento el experimento que ya presenté aquí de configurar un LLM para que actúe como un tutor que aconseja a los estudiantes cambios en sus programas para que cumplan ciertas directrices que reforzamos en nuestra asignatura (buenas prácticas de Programación Funcional).

Por ahora, el grupo de trabajo de Moodle está restringido a la UA, por lo que he subido también el vídeo a YouTube para que cualquiera pueda verlo y comentarlo.

No hay nada demasiado distinto a lo que ya conté aquí, pero puede ser interesante ver el ejemplo del tutor en funcionamiento. Y al final del vídeo lanzo una propuesta bastante evidente: necesitaríamos poder disponer de algún servicio propio que nos permitiera a profesores y estudiantes realizar experimentos con LLMs. Configurarlos, darles directrices y ponerlos en marcha para que sean probados. Lo comentaremos y discutiremos en el propio grupo de trabajo, a ver si sacamos alguna conclusión.

📖 Un libro

He seguido leyendo la trilogía de Liu Cixin. En concreto su segunda parte, El bosque oscuro. Es un libro mucho mejor que el primero. Más profundo, con más ideas, más personajes y bastante mejor escrito. Se publicó en 2008, dos años después del primero y se nota la evolución de Liu y su mayor madurez (o que, después del éxito del primero, pudo por fin dedicarle al libro el tiempo que necesitaba).

La primera temporada de la serie de Netflix adapta hasta la mitad de este segundo libro. Cuando llegue al momento en el que termina la serie lo dejaré y lo volveré a coger un par de meses antes de que se estrene la segunda temporada (que, por cierto, Netflix todavía no ha anunciado).

📺 Una serie

Nos está gustando mucho (vamos por la mitad) la serie inglesa de AppleTV+ Historial delictivo. Una serie policiaca, sobre los suburbios de Londres, en la que Cush Jumbo debe enfrentarse a lo que parece un caso de corrupción policial en el que está implicado Peter Capaldi.

Dos estupendos actores que ya hemos visto recientemente en otras producciones. A Capaldi en la buenísima (y poco conocida) The Devil’s Hour de Prime. Y a Jumbo como abogada en The Good Fight.

Y terminamos con una lista de las películas que hemos visto esta quincena a las que he dado cuatro o más estrellas en Letterboxd:

The Host (2006)

28 semanas después (2007)

Anatomía de una caída (2023)

La gran exclusiva (2024)

La primera profecía (2024)

¡Hasta la próxima quincena, nos leemos! 👋👋

La entrevista es de principios de los 90, antes de internet, y es buenísima por las explicaciones que da Jobs para justificar la importancia de los computadores. En aquella época era necesario dar estas justificaciones para convencer a futuros compradores. Igual que ahora con las Vision Pro. También he encontrado una presentación de Jobs más antigua todavía, de una de las primeras veces en las que usa la metáfora. La presentación es de 1980 y ahí ya están muchas de las ideas que hicieron que Apple revolucionara los ordenadores: presentar el computador como una herramienta para todo el mundo (no solo para el mundo empresarial) y hacer que su uso sea personal, fácil e intuitivo.