Del 16 al 31 de mayo (#10 de 2024)

Herramienta de subtitulado de la UA, Microsoft presenta los Copilot+ PC, preguntas para la WWDC24, resúmenes de Google hechos con IA, What if para las Vision Pro y Mulán.

Después del pasado número especial, este viernes nos toca repasar lo sucedido en la quincena pasada, del 16 al 31 de mayo.

¡Vamos allá! ¡Muchas gracias por leerme!

🗞 Noticias

1️⃣ José María Fernández Gil es un crack. Es especialista en accesibilidad digital y desarrollador de aplicaciones. Trabaja desde 2009 en la Universidad de Alicante, primero en el CAE (Centro de Apoyo al Estudiante) y después como responsable de la Unidad de Accesibilidad Digital. Lleva quince años desarrollando aplicaciones que ayudan a las personas y promoviendo la accesibilidad de las páginas y webs de la UA.

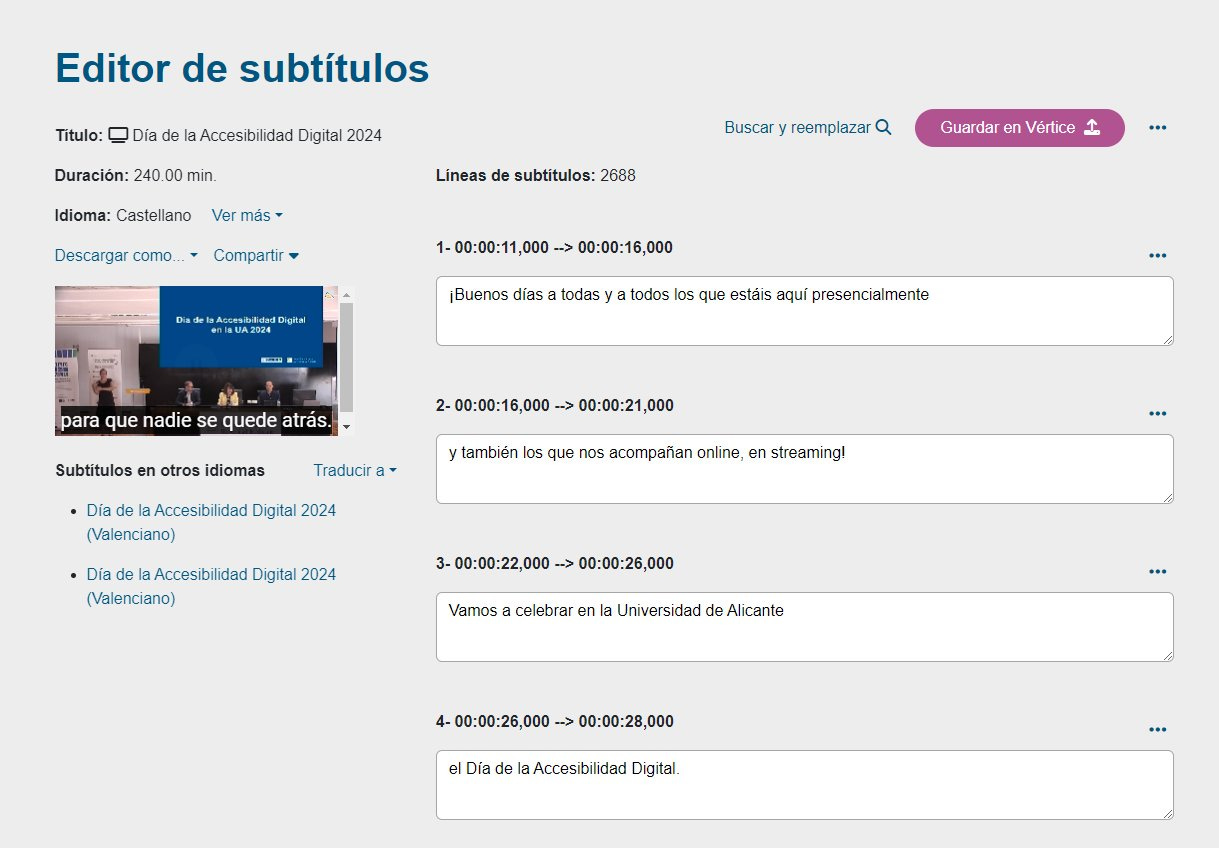

El 21 de mayo, después de un desarrollo de más de un año, presentó una herramienta de subtitulado y transcripción, una aplicación interna [Subtitulado y transcripción - ua.es] que permite generar automáticamente subtítulos para los vídeos que se publican en la plataforma de la UA.

Conocí la aplicación en una versión beta que me ofreció José María. La probé y me sorprendió lo bien que funcionaba y lo útil que era. En muy pocos minutos, después de retocar alguna transcripción que no había salido bien (algún nombre propio, o referencia que el modelo no conocía), tenía completamente subtitulado un vídeo de más de 20 minutos de duración. Un trabajo que, sin la herramienta, me hubiera llevado varias horas.

Según comenta José María, la aplicación utiliza el modelo abierto de reconocimiento del habla Whisper, y ya ha subtitulado más de 2.000 vídeos y 1.500 horas de vídeo, en la fase de pruebas.

Ahora que ya está en producción, integrada en la web de la UA, será un recurso de enorme valor. Hará posible que todos los vídeos creados por el personal de la UA vayan acompañados de subtítulos y, de esta forma, puedan ser accesibles a las personas sordas y con déficit auditivo. Y no solo a ellas, sino a todo el mundo. Las opciones de accesibilidad son algo que nos facilita la interacción en muchas situaciones y que, tarde o temprano, todos terminaremos usando.

¡Enhorabuena por el gran trabajo!

2️⃣ El 20 de mayo, Microsoft presentó en un evento especial llamado Introducing Copilot+ PCs [microsoft.com y youtube.com], una nueva versión de su tablet/portátil Surface Pro con el nuevo chip ARM Snapdragon X Elite de Qualcomm [The new, faster Surface Pro is Microsoft’s all-purpose AI PC - theverge.com]. Esta tablet es la respuesta de Microsoft a los portátiles de Apple [A first look at Microsoft’s new Surface Pro with Arm chips inside - theverge.com]. El chip ARM de Qualcomm, junto con los anunciados de otros fabricantes, pretende competir con los chips ARM de Apple, que han demostrado unas buenísimas prestaciones a nivel de consumo y eficiencia computacional. Veremos si esta vez se populariza esta versión de Windows para ARM1.

Un resumen de las características de esta tablet se puede ver en el anuncio de Microsoft. Quizás sea porque estoy acostumbrado a los anuncios de Apple de la época de Jonny Ive, pero el estilo me pareció una copia de esos tiempos.

Para la popularización de estos ordenadores con ARM puede ser fundamental la IA. Satya Nadella se volcó en las novedades de Windows relacionadas con IA y presentó la nueva gama de ordenadores compatibles llamados “Copilot+ PCs” [Microsoft announces Copilot Plus PCs with built-in AI hardware - theverge.com], también basados en la arquitectura ARM y en el chip de Qualcomm.

Nadella se volcó en el concepto del ordenador “inteligente”, que nos entiende y nos ayuda usando una interfaz conversacional. La idea de Microsoft del “copiloto” inteligente que observa lo que estamos haciendo y al que podemos pedir ayuda en cualquier momento. En sus propias palabras, al principio del evento:

“La nueva interfaz de usuario [facilitada por la IA] es multimodal y puede soportar texto, imágenes, video, tanto como entrada como salida. Vamos a tener eso. Vamos a tener una memoria que retiene el contexto importante, que recuerda nuestro conocimiento y datos personales en todas las aplicaciones y dispositivos. Y vamos a tener nuevas capacidades de razonamiento que nos ayuden a completar tareas complejas.

Estamos entrando en esta nueva era donde las computadoras no solo nos entienden, sino que también pueden anticipar lo que queremos y nuestras intenciones.”

La verdad es que, viendo la presentación, no presentaron nada extraordinario relacionado con estos copilotos, sino fue más una declaración de intenciones y de aspiraciones futuras. La marca “Copilot+PC” (un nombre bastante malo) es un recurso de marketing para definir un conjunto mínimo de especificaciones de hardware (memoria, disco duro, procesador) que deben tener los ordenadores que vayan a soportar las nuevas características de IA que se van a introducir en Windows 11.

Entre estas características, además de algunas aplicaciones de traducción y transcripción automática en videollamadas o de generación y retoque de imágenes en fotos, lo más notable fue la presentación de la funcionalidad de Windows que han llamado Recall. Dedicaron más de la mitad de la presentación a hablar de esta funcionalidad.

Se trata de una utilidad que graba continuamente toda la interacción del usuario con el ordenador y responde de forma inteligente a cualquier consulta. Por ejemplo, imagina que en la última semana visitaste una página de un hotel preparando un viaje, pero no recuerdas qué página en concreto. Puedes preguntárselo a Recall y te responderá. Y así con cualquier cosa que quieras recuperar referida a algo que has hecho con el ordenador: un correo electrónico que respondiste, un vídeo que viste o una noticia que leíste [New Windows AI feature records everything you’ve done on your PC - arstechnica.com].

La aplicación ha generado alguna polémica, por las implicaciones que tiene en cuanto a privacidad [Windows AI feature that screenshots everything labeled a security ‘disaster’ - theverge.com y Windows Recall demands an extraordinary level of trust that Microsoft hasn’t earned - arstechnica.com].

Microsoft asegura que todo el proceso es local, se realiza en el ordenador, y que ellos no tienen acceso a nada de lo que el ordenador graba. Pero muchos lo ven complicado. ¿Se podrá asegurar lo mismo con el fabricante del PC? ¿Quién me asegura que Xiaomi o Dell (por mencionar dos fabricantes) no accedan a mi historial? Por ahora todo es un anuncio y la funcionalidad todavía no se ha puesto en producción. Veremos si al final termina lanzándose y con qué restricciones.

A mi la funcionalidad me parece utilísima y me encantaría que Apple la incorporara en MacOS. Los usuarios de Mac tenemos la utilidad Rewind, que hace algo parecido. Pero la verdad es que no me fío de la seguridad de mis datos en mandos de una startup. ¡Apple, por favor, cómprala e integra el producto en MacOS!

3️⃣ Hablando de Apple y de funcionalidades relacionadas con la IA, la semana que viene se espera un aluvión de noticias en el evento inaugural de su conferencia anual de desarrolladores, la WWDC24. Ahora mismo no tenemos todavía noticias, pero sí muchas preguntas.

En el podcast Upgrade, Jason Snell y Mike Hurley hacen la quiniela del evento. Muy entretenido.

Mis preguntas:

¿Van a presentar algún LLM local, que funciona en el móvil? ¿Qué uso le van a dar?

¿Se va a confirmar el acuerdo con OpenAI? ¿En qué va a consistir, en acceso a GPT-4 o en otro modelo específico ad-hoc para Apple? ¿En qué servicio va a integrar Apple este acceso, va a ser algo gratuito de la nueva versión de iOS, o será parte de un servicio de pago? ¿Dónde se van a integrar las consultas a este modelo? ¿En Siri, en alguna aplicación específica o difuminado en múltiples funcionalidades “inteligentes” de iOS?

¿Va a haber un copilot para Xcode, entrenado para Swift y SwiftUI? ¿Va a haber un copilot para Keynote (por ejemplo), que haga automáticamente las diapositivas a partir de un texto previo, al estilo de lo que está haciendo Microsoft?

¿Cuál va a ser el enfoque de Siri? ¿Un agente conversacional que puede consultar la web y resumir la información que encuentra? Eso sería intentar competir con OpenAI y no creo que vayan por ahí. ¿O un agente que puede usar las distintas aplicaciones del móvil? Por ahí creo que irán los tiros. Al menos, es lo que anuncia Gurman. Creo que usarán toda la infraestructura que tienen ya montada con Atajos, para integrarla en un modelo de lenguaje que use Siri.

Pronto conoceremos las respuestas.

4️⃣ Google ha empezado a integrar los resúmenes generados por IA (llamados AI Overviews) en los resultados de las búsquedas. Lo ha empezado a hacer de forma tímida, tanteando la funcionalidad. Se han hecho virales varias contestaciones fallidas (la famosa “ponle pegamento al queso para la pizza”) [Google’s “AI Overview” can give false, misleading, and dangerous answers - arstechnica.com].

Google ha respondido, el 30 de mayo, disculpándose, diciendo que son excepciones, que el sistema está funcionando y que, en cualquier caso, todo se va ir mejorando [AI Overviews: About last week - blog.google]:

“Hemos estado vigilando atentamente los comentarios y los informes externos, y tomando medidas sobre el pequeño número de resúmenes generados por IA que violan las políticas de contenido. Esto significa resúmenes que contienen información potencialmente dañina, obscena o de otro modo violatoria. Encontramos una violación de la política de contenido en menos de una por cada siete millones de consultas únicas en las que aparecieron resúmenes generados por IA.

A la escala de la web, con miles de millones de consultas cada día, es inevitable que haya algunas rarezas y errores. Hemos aprendido mucho en los últimos 25 años sobre cómo construir y mantener una experiencia de búsqueda de alta calidad, incluyendo cómo aprender de estos errores para mejorar la búsqueda para todos. Seguiremos mejorando cuándo y cómo mostramos los resúmenes generados por IA y fortaleciendo nuestras protecciones, incluyendo para casos excepcionales, y estamos muy agradecidos por los comentarios continuos.”

Todavía no sabemos si Google va tirar por ahí definitivamente. Se trata de un cambio de estrategia muy grande, y Google debe ir con pies de plomo para no canibalizar su propio tráfico web y el de los sitios de sus socios, lo que podría perjudicar su modelo de negocio y las relaciones con los creadores de contenido.

Antonio Ortiz ha tocado el tema varias veces en Error500 [La crisis de Google antes de su verdadera crisis, Google tiene que decidir a quien va a perjudicar con su cambio en el buscador. Y rápido] y lo resumen muy bien en el último episodio de Monos estocásticos.

“Google creo que todavía no ha asumido el jardín en el que se está metiendo.

Medios que se te van a echar encima, creadores de contenido a los que ya no envías tráfico, la desaparición de ese tráfico por culpa de que tú respondes al usuario y ya no tiene motivos para venir a mi página.

El problema de fondo es que Google, en este salto, creo que realiza un cambio tal de identidad, un cambio tal de su rol respecto a la información y el contenido …, cambia tanto tu rol en términos económicos, términos políticos, en las responsabilidades que asumes, que creo que todos los procesos, cultura y tecnología que tienes para el rol anterior tienen que ser repensados.

Este es un salto tan pistonudo, si me permita la expresión del siglo pasado, que hará que se tambaleen los cimientos de Google si siguen por este camino.”

Con respecto al incidente, para mi es un claro “cherry-picking” provocado por la dinámica de las redes sociales, que favorece que se hagan virales estos pequeños incidentes (alguna vez incluso inventados) en lugar de promover un análisis objetivo y no sesgado.

Como último elemento para el análisis del futuro de Google, en el podcast Decoder, Nilay Patel, editor jefe de The Verge entrevista a su CEO Sunday Pichai.

Patel es bastante inquisitivo y se nota que es parte en el asunto (es representante de un medio de comunicación que puede verse afectado en sus ingresos). Pero Pichai se defiende bien y parece bastante convencido de que el futuro del modelo de negocio de Google pasa por la integración de la IA en los resultados de las búsquedas:

"Las personas están respondiendo muy positivamente. Es uno de los cambios más positivos que he visto en las búsquedas, según las métricas que observamos. Las personas interactúan más cuando se les proporciona contexto. Esto les ayuda a entender mejor, y también se comprometen con el contenido subyacente. De hecho, si incluyes contenido y enlaces dentro de los resúmenes generados por IA, obtienen tasas de clics más altas que si los pones fuera de estos resúmenes."

5️⃣ Las Vision Pro me interesan como una novedad tecnológica, por la integración de tecnologías y algoritmos avanzados que Apple ha desarrollado y pueden ser usados por los desarrolladores en forma de APIs (hemos visto muchos detalles de esto en la pasada WWDC23 [Videos sobre VisionOS en WWDC23- apple.com] y veremos mucho más todavía en la próxima WWDC24).

Pero también me interesan sobre todo por las nuevas experiencias que pueden crearse en ellas.

Tanto experiencias computacionales y de interacción con la información, como la imagen anterior del artículo RealitySummary: On-Demand Mixed Reality Document Enhancement using Large Language Models [paper - arxiv.org y post de Andy Matuschak - x.com] con un ejemplo de cómo se puede usar la realidad aumentada para complementar la lectura de un documento, como experiencias de entretenimiento inmersivas, como las que ya hemos visto otras veces en esta newsletter.

En la línea de estas experiencias inmersivas, el 30 de mayo, Marvel publicaba su primera "historia inmersiva" para las Vision Pro: un episodio de la serie animada "What If...?" de casi una hora de duración. Producido por el estudio ILM Immersive, una división de la famosa Industrial Light & Magic, se trata de una experiencia que combina películas 3D, escenas inmersivas, escenas en realidad mixta e interacciones en primera persona.

A Wes Davis, de The Verge no le impresionó demasiado [Marvel’s What If…? Vision Pro app is an awkward mix of video game and movie - theverge.com], pero a Jason Snell sí que le convenció [Review: “What If?” shows off the Vision Pro’s strengths - sixcolors.com]:

No es un vídeo inmersivo ni un juego. Es algo entre los dos, un experimento de medios-mixtos, de alrededor de una hora de duración, que intenta usar todas las características de las Vision Pro para conseguir una experiencia de entretenimiento respetable. [...] Es difícil juzgar "What If?" en su totalidad, porque realmente parece una muestra de cómo este tipo de entretenimiento podría evolucionar en el futuro. ¿Hay espacio para algo que sea más interactivo que ver televisión, pero menos interactivo que un videojuego completo? No tengo idea. Pero sí sé que la hora que pasé con "What If?" fue tal vez la mejor hora que he pasado con el dispositivo desde que lo obtuve. Si Apple está buscando una aplicación que demuestre todas las características del Vision Pro en su mejor forma, "What If?" podría ser la respuesta.

En el episodio #1931 del podcast Voices of VR, se entrevista al productor ejecutivo Shereif Fattouh y a la directora de arte Indira Guerrieri sobre el proceso de creación de esta historia:

Shereif Fattouh:

Muchas de las texturas de los assets ya estaban hechas de las temporadas, así que básicamente tuvimos que tomar todos estos assets y asegurarnos de que de alguna manera existieran en el espacio, en un espacio 3D, lo cual realmente nos obligó a reflexionar sobre cómo íbamos a mantener el aspecto 2D o cómo íbamos a mezclarlo con los aspectos inmersivos. Y terminamos con una especie de combinación de ser realmente fieles a la hermosa obra de arte, al hermoso trabajo que se hizo, y agregar la dimensión espacial haciendo todo un poco más realista en algunos elementos, como los entornos inmersivos.

Indira Guerrieri:

Aunque estamos explorando un medio nuevo, mucho de esto ya está en los juegos tradicionales, especialmente cuando estás haciendo un contenido inmersivo o cinemático para juegos basados en narrativa. El balance está en cuánto va a ser interactivo, el nivel de agencia que tienes en la interactividad, y en cuánto de la historia va a estar en los hombros del jugador. En este caso, no estamos haciendo un juego, sino una nueva forma. Una historia inmmersiva, totalmente subjetiva, con ciertos elementos interactivos.

Podemos ver la experiencia completa en vídeos que muchos usuarios han subido a YouTube. Por ejemplo, el gameplay completo del youtuber Nathie [Marvel's: What If Experience On Apple Vision Pro Is A Blast! (Full Gameplay) - youtu.be ] ha alcanzado en tres días casi 40.000 visualizaciones. Y el usuario iBrews la presenta también completa [WHAT IF? in Apple Vision Pro - lots of commentary - youtu.be], con muchos más comentarios y pruebas exhaustivas de interacción (y los títulos de crédito completos al final, que muestran la cantidad de personas que han participado en la creación de la historia).

A continuación podemos ver algunos vídeos cortos con ejemplos de los distintos elementos que usan en la experiencia.

Empieza con realidad mixta, con el Vigilante y Wong, personajes que nos guían en la historia. Aquí vemos a Wong, saliendo de un portal y entrando en nuestra realidad:

Las películas en 3D son una de las características más interesantes de las Vision Pro. Los fragmentos de cristal se usan de forma muy inteligente para proyectar en ellos historias animadas en tres dimensiones.

Las experiencias inmersivas son escenarios estáticos en los que vemos una escena que se desarrolla frente a nosotros. Los escenarios se extienden alrededor nuestro y podemos mirar a los lados, y arriba, dependiendo de donde se esté desarrollando la escena. A veces los personajes se acercan y los vemos a nuestro lado. La sensación de inmersión debe ser buenísima. Eso sí, no podemos movernos hacia adelante ni hacia atrás, solo girar la cabeza.

En resumen, a mi me ha parecido una producción de enorme calidad, que va a marcar el estándar durante mucho tiempo para las futuras experiencias que se realicen para las Vision Pro. Ha conseguido hacer algo muy complicado como es combinar todas las posibilidades del dispositivo en una experiencia unificada de casi una hora de duración.

Estoy deseando que las vendan en España, para pasarme por la tienda de la Condomina a probarlas.

6️⃣ El 20 de mayo recibí el número Setting the Stage for 'Mulan' de la estupenda newsletter Animation Obsessive. En él se explica la enorme contribución del diseñador de producción Hans Bacher a Mulán (1998). Sin él, la película hubiera sido totalmente distinta.

Bacher definió un estilo visual único, que emulaba las pinturas tradicionales chinas, manteniendo al mismo tiempo la esencia de Disney. Su enfoque inicial, denominado "simplicidad poética", enfatizó el minimalismo y la claridad, inspirándose en las tradiciones artísticas chinas donde los paisajes a menudo representan formas simplificadas, dejando los detalles a la imaginación del espectador.

Los responsables del estudio, sin embargo, consideraron los diseños iniciales demasiado simples y pidieron más detalles y más trabajo en los fondos. Esto implicó un proceso creativo de equilibrar la simplicidad artística con las expectativas detalladas del estilo de animación de Disney.

La influencia de Bacher se extendió más allá de su visión conceptual. Guió activamente la dirección artística de la película a través de guías de estilo exhaustivas que delineaban principios fundamentales para la composición de las tomas. Estos principios incluían mantener un equilibrio entre elementos ocupados y tranquilos, líneas rectas y curvas, y espacios positivos y negativos. Hay disponible en internet una versión en PDF de estas guías [Hans Bacher, 1995: Mulan Style Guide - archive.org]. También Bacher ha recopilado en su blog muchas escenas y diseños iniciales (One1more2time3’s Weblog).

Su insistencia en estas reglas estilísticas aseguró una apariencia cohesiva a lo largo de la película, haciendo que cada escena fuera visualmente atractiva y narrativamente clara. Al corregir diseños y fondos, y liderar al equipo artístico, la visión de Bacher fue crucial para moldear Mulán en una película que no solo fue un éxito comercial, sino también una obra de narración visualmente rica que resonó con audiencias en todo el mundo.

Una galería con algunas de las escenas de la película:

Mulán es una de las películas de Disney que más hemos visto y que más nos gusta a toda la familia. Me gusta todo de ella: los diseños, los colores, los fondos, el montaje, la animación, los personajes, la historia. También es muy curiosa y funciona muy bien la mezcla de animación por ordenador y animación tradicional. Los gráficos por ordenador son muy sutiles en algunas escenas y muy espectaculares en otras, como el ataque de los hunos.

Me fascinó tanto la película, que cuando vi en Ateneo su libro de arte me lancé a comprarlo, a pesar de las 10.000 pesetas y pico que costaba (más de 60€, sin ajustar la inflación).

Es una joya, precioso. Fue uno de los primeros libros de arte de películas que compré. Después cayeron más, pero este sigue siendo uno de los que más aprecio. Por si queréis ver su contenido, aquí dejo un vídeo:

👷♂️ Mis quince días

Vamos directamente a las películas y las series. Nada nuevo en cuanto a libros ni a otros proyectos.

🍿 Cine

Repasando mi letterboxd (cada vez me fio menos de mi memoria), destaco de estos quince días la película Furiosa, la continuación de la saga Mad Max (y, sobre todo, precuela de Fury Road). Dirigida por George Miller (79 años) y protagonizada por Anya Taylor-Joy y un irreconocible Chris Hemsworth. Me pareció una película súper entretenida, con una fotografía y unos paisajes espectaculares y con unas secuencias de acción buenísimas. Personajes con los que empatizas y una “origin story” muy redonda, que explica muy bien toda la vida previa de Furiosa, hasta convertirse en la heroína de Fury Road.

📺 TV

De las series que hemos visto en la quincena, destaco la temporada 2 de Bosch Legacy en Prime. Protagonizada por el bueno de Titus Welliver, la joven Madison Lintz (que hace estupendamente el papel de su hija Maddie) y los siempre fieles amigos de Bosh, Mimi Rogers y Chang.

La serie comienza con un par de episodios iniciales que son pura adrenalina, con Harry intentando encontrar a la desaparecida Maddie. Sigue un resto de temporada en la línea de las anteriores, que nos da todo lo que nos gusta de la serie. Y termina con un gran giro final, en los últimos cinco minutos, para que no decaiga la cosa de cara a la ya confirmada temporada 3.

¡Hasta la próxima quincena, nos leemos! 👋👋

Microsoft lleva más de una década (desde 2012, con el lanzamiento de Windows RT) haciendo versiones ARM para windows. En 2017 lanzó Windows 10 on ARM y en 2021 Windows 11 on ARM. Ambos sistemas operativos funcionan en la Surface Pro y otros dispositivos de Lenovo y Samsung, pero nunca han sido muy populares.